别被AI取代,成为AI通才:你的8项生存技能指南

改变工作”的问题,而是“我们如何适应才能生存”。 过去的建议是:成为某一领域的专家。但当AI能以更快更便宜的方式完成你的专业技能时,怎么办?达尔文说的不是最强或最聪明的人能生存下来,而是最适应环境变化的人。

改变工作”的问题,而是“我们如何适应才能生存”。 过去的建议是:成为某一领域的专家。但当AI能以更快更便宜的方式完成你的专业技能时,怎么办?达尔文说的不是最强或最聪明的人能生存下来,而是最适应环境变化的人。

曾经,写一份简洁有力的简历、搭配量身定制的求职信,是找工作的“黄金标准”。 但现在,这一切正在迅速变化。虽然许多公司仍然要求提供简历,但越来越多的招聘方已经不再把它当作关键筛选依据。原因很简单:传统简历太静态、太片面,远远无法满足现代招聘的需求。 下面,我们就来看看为什么简历正在失宠,又有哪些新趋势正在取而代之。

标题:Shopify CEO 的 AI 招聘新政,让 40 岁以下的人都该警惕 副标题:在 AI 加速冲击职场的时代,年轻人如何不被淘汰? 作者:Michael Lim 原文发布于 2025 年 4 月 2022 年以来,从 ChatGPT 问世,到图像生成、视频生成、代码辅助,AI 的每一次进化都带来行业洗牌。 这次轮到招聘流程了。 Shopify CEO Tobi Lutke 最近发布的一份内部备忘录,引发了热议: "在请求增加人手或资源前,员工必须先证明自己无法通过 AI 完成任务。" 这不是一句口号,而是一道明确的公司政策。 换句话说:你需要为“雇一个真人”

现在我也提供一个超级通用智能体给大家使用,效果比Manus还要好。

你可能已经玩过 ChatGPT了,但玩不够,不如开始 "用它创业" 。 ChatGPT最新的图像生成 API,已经被 Adobe、Airtable、OpusClip 等公司接入到他们的产品里。而对你而言,这是一个可以快速进场的红利池。 你不需要重新训练AI模型,也不需要写复杂编程。你需要的,是把这个图生成 API 包裹成一个具有实际用途和商业模型的小业企产品。

人工智能(AI)智能体正在改变我们的生活和工作方式。在《零基础AI智能体入门到精通》课程的第一节公开课中,我们深入探讨了智能体的基础知识、应用场景以及未来的潜力。我是史丹福机器人庞博士,我将带你快速了解智能体的核心价值,以及如何通过这门课掌握这一前沿技术。

你可能已经听过无数次“AI智能体(AI Agent)”这个词,但它到底是啥?为什么所有人都在说它是未来? 有些解释太复杂,有些又浅得离谱。 这篇文章不卖关子,手把手带你理解AI智能体,0基础也能秒懂。 我们分三层讲清楚:

三年来我一直写科技内容,但真让我“上头”的,是提示词工程(Prompt Engineering)。 用得好,AI可以写代码、讲故事、解数学题;用得差,结果就像你让狗去捡球,它叼回来一只袜子。 这就是提示词工程的本质:不是编程,而是“学会怎么跟AI讲话”。 这篇内容我参考了 Google 技术专家 Lee Boonstra 写的《Prompt Engineering白皮书》,用超简单的方式带你上手。

PT-4.5发布已有一个多月,但其背后的研发历程,直到今天才首次公开。 OpenAI CEO奥特曼携三位核心研发负责人,在最新的官方播客中,完整还原了GPT-4.5从设想到落地的全过程。 这是关于AI工程实践、技术突破、算力管理、数据瓶颈,以及研发文化的深度案例。

过去三年,AI技术快速迭代,新的模型、工具层出不穷。 但真正能创造收入、形成商业闭环的AI项目,直到最近才逐渐浮出水面。 2025年,是AI从“炫技”走向“实用价值”的重要转折点。AI不再只是技术爱好者的玩具,而是创业者、开发者变现的新武器。

长期以来,免费试用(Free Trial)被视为SaaS产品获客的标准配置。但随着行业竞争的加剧、AI工具的普及,以及用户对软件价值体验的期待日益提高,传统的免费试用策略正面临系统性失效。 越来越多的创业公司和市场领先者,正在主动放弃“7天试用”“无需信用卡”的传统打法,转而采用以“结果承诺(Outcome Guarantee)”为核心的产品定价与营销策略。这背后不仅是用户行为的改变,更是SaaS行业对价值交付逻辑的重构。

2023年,一个名为 Cursor 的AI编程工具在全球开发者社区中迅速走红。这款由25岁麻省理工学院毕业生 Michael Truell 及其团队打造的代码编辑器,在短短两年时间内,将公司估值推升至100亿美元,成为AI编程赛道中的标志性创新产品,也引发了整个软件开发产业链对“AI原生”工具的深度关注。

AI startup

外界老吹嘘“必须要拿钱才能撑起一门体面的生意”,其实就是神话罢了。研究了无数自给自足(Bootstrap)的案例后,发现它们都有某些共性。接下来这份清单,就能一步步教你如何利用“客户付费+聪明分配资源”来构建年收入百万美元的业务。

AI class

这里是一位网友的文章,就像我在AI和大模型六门课里跟大家讲的,他每天只用两个小时,靠AI开始赚钱,每周赚1000刀(7000人民币)。最后他说了一句我两年来一直跟我的粉丝讲的话:AI不会取代你,但会用AI的人会取代你。

AI chip

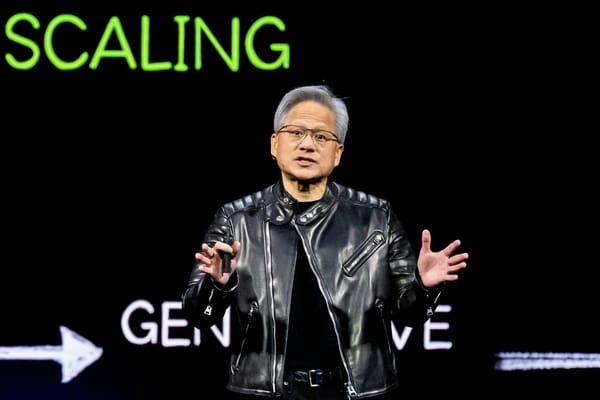

如果你对AI或者投资稍微感兴趣,那你应该读一读这篇文章。 英伟达CEO黄仁勋在GTC大会上发表了长达两个小时的主题演讲,展示了英伟达未来的路线图,这场大会也被称为“AI界的春晚”。 这次演讲信息量巨大,相当于讲了三年的内容,但用的术语和行话让大多数人听得一头雾水。 那么,真正重要的要点是什么?哪些内容会决定这个行业未来几年的走向? 如果英伟达打个喷嚏,整个AI行业都要感冒。下面是你需要知道的关于AI硬件、软件、机器人和投资的全部要点。

AI agent

在人工智能(AI)领域,许多工程师专注于模型训练、数据处理和算法优化,而往往忽略了前端开发。然而,在当今的技术环境下,能够构建用户友好的Web应用程序对于AI工程师来说是一项不可忽视的技能。尤其是对于希望将自己的AI项目产品化,或者想要更好地与前端开发团队协作的工程师,掌握Next.js可以带来巨大的优势。

Nvidia

一年一度的英伟达的 GTC ,也是硅谷最大的人工智能盛会,下个星期就要召开了,想拿到线上参会的免费注册码吗?下面我就给大家送福利了。GTC 是英伟达一年一度最大的盛会,英伟达的创始人和 CEO ,也就是我们爱称的黄教主,每次都会在这个会议上发布他们最新的人工智能芯片和各种最新的 AI 应用。在去年 GTC 的最后,老黄带出了一堆机器人,正式宣布英伟达进入巨深智能的领域。那今年的 GTC 也有很多机器人的讲座,我也给大家总结了一些,这里边还有中文的讲座和观看的 party ,大家可以用下面的链接或者扫下面图里的二维码免费注册。 GTC大会的免费注册

Apple Silicon

彭博社记者Mark Gurman透露了几项iPhone 16系列的硬件升级,如不锈钢电池、新的48MP超广角镜头和重新设计的相机按钮。这些“升级”是否足以重振苹果在智能手机市场的存在?

AppleM3

他们说人工智能是当今科技界的核心。然而,没有人提到的是规则已经不同了。这已经成为一场合作游戏。

Jace AI

与过去的助手不同,Jace 独立运作,处理任务和解决问题无需你的持续输入。那么,这种自给自足的 AI 如何成为你生活中无价的资产呢?让我们一探究竟。

AI class

史丹福机器人庞博士已经开了五门课给对AI,尤其是ChatGPT和大模型有兴趣的同学,正在开第六门课,准备开第七门课。 可以加入金粉群,可以终生免费听庞博士的所有收费课程(不包括考试认证费用),包括以前和今后的所有课程,永久免费。

OpenAI

作者:Andrew Best 发表于:Plain English 中的人工智能 阅读时间:3分钟 OpenAI 发布了他们最新的GPT-4o模型,这是迄今为止最好的大语言模型。最令人惊讶的部分不是这个模型有多么出色,而是他们允许所有人免费使用它。 这让我开始思考: 为什么GPT-4o是免费的? OpenAI在想什么? 他们的大部分收入来自于付费用户,这些用户每月支付20美元订阅ChatGPT Plus。我自从推出以来一直在付费使用,现在我在想是否应该取消订阅。 这背后一定有某种理由。 以下是我刚刚制作的视频: 以下是我对为什么GPT-4o免费以及ChatGPT全面统治计划的看法。 大规模采用 OpenAI 希望尽可能多的人使用他们的产品。 竞争加剧 Meta的Llama 3、Google的Gemini、Anthropic的Claude 3……这些都是非常好的模型。当OpenAI推出他们的第一个模型时,他们是唯一的选择,但现在,他们的GPT-3.5模型已经落后了。他们需要一些伟大且免费的东西来夺回市场份额。 训练GPT-5及更高版本 更多的免费用户意味着OpenA

AI agent

AI代理框架 Omar Santos 发表于 Bootcamp 阅读时间:5分钟 AI代理框架 聊天机器人和协同操作员是2023年的热门话题,而在2024年及以后,代理和代理框架成为了新的焦点。AI代理框架和工具在开发可扩展和高效的AI自主系统中发挥着重要作用。这些框架和工具使开发人员能够构建、部署和管理针对各种应用的AI代理,从数据处理到多代理协调。这些AI代理工具和框架的领域丰富多样,反映了AI技术的快速发展。 几周前,我写了一篇关于LangGraph的文章。LangGraph的主要优势在于其实现循环工作流程的能力。计算工作流程中的循环允许某些过程的重复,基于不断变化的状态进行连续的交互和决策。这在大语言模型(LLM)像代理一样行动的场景中非常重要,它们参与对话或决策循环,其中一个步骤的结果影响下一个步骤。 LangGraph、LangChain、LlamaIndex和类似的库使得创建AI代理和应用程序变得更容易。AI代理的领域正迅速增长! 如果你不相信我所说的这个列表正在迅速增长,只需看看E2B关于AI代理领域的以下图片。这还不是所有基于代理的工具和框架的完整列表:

AI chip

作者:Shakir 发表于 Bootcamp 阅读时间:4分钟 2020年,苹果在决定放弃基于Intel的硬件并使用自己的设计(Apple Silicon)时声称其处理器超高效。他们甚至大胆地移除了2020年M1 MacBook Air中的风扇。 虽然在首次发布后的几年里,这些无风扇型号似乎存在需要冷却解决方案的争议。 然而,毫无疑问,这些处理器效率极高,这在全球的苹果和科技爱好者中掀起了新的热潮。因为在YouTube上的任何评测视频中它们看起来都非常快。 然后,Intel会制造出比苹果更快的新芯片。这通常是常规的做法。当一个新竞争对手进入市场时,看到这种情况总是令人振奋。 Intel和AMD的战斗是经典的竞争。更多的竞争总是对消费者有利。 但是,它与Intel处理器有什么不同呢? 从物理上看,苹果和Intel在底层架构上是不同的。 架构 * Apple Silicon:基于ARM架构(M1, M2, M3) * Intel:x86-64架构 Apple Silicon基于ARM架构,而不是Intel的x86-64架构。 这种架构体现在CPU执行最基本操作(如算术运算等)