AI智能体

零基础AI智能体入门到精通

人工智能(AI)智能体正在改变我们的生活和工作方式。在《零基础AI智能体入门到精通》课程的第一节公开课中,我们深入探讨了智能体的基础知识、应用场景以及未来的潜力。我是史丹福机器人庞博士,我将带你快速了解智能体的核心价值,以及如何通过这门课掌握这一前沿技术。

AI智能体

人工智能(AI)智能体正在改变我们的生活和工作方式。在《零基础AI智能体入门到精通》课程的第一节公开课中,我们深入探讨了智能体的基础知识、应用场景以及未来的潜力。我是史丹福机器人庞博士,我将带你快速了解智能体的核心价值,以及如何通过这门课掌握这一前沿技术。

AI agent

你可能已经听过无数次“AI智能体(AI Agent)”这个词,但它到底是啥?为什么所有人都在说它是未来? 有些解释太复杂,有些又浅得离谱。 这篇文章不卖关子,手把手带你理解AI智能体,0基础也能秒懂。 我们分三层讲清楚:

AI agent

AI代理框架 Omar Santos 发表于 Bootcamp 阅读时间:5分钟 AI代理框架 聊天机器人和协同操作员是2023年的热门话题,而在2024年及以后,代理和代理框架成为了新的焦点。AI代理框架和工具在开发可扩展和高效的AI自主系统中发挥着重要作用。这些框架和工具使开发人员能够构建、部署和管理针对各种应用的AI代理,从数据处理到多代理协调。这些AI代理工具和框架的领域丰富多样,反映了AI技术的快速发展。 几周前,我写了一篇关于LangGraph的文章。LangGraph的主要优势在于其实现循环工作流程的能力。计算工作流程中的循环允许某些过程的重复,基于不断变化的状态进行连续的交互和决策。这在大语言模型(LLM)像代理一样行动的场景中非常重要,它们参与对话或决策循环,其中一个步骤的结果影响下一个步骤。 LangGraph、LangChain、LlamaIndex和类似的库使得创建AI代理和应用程序变得更容易。AI代理的领域正迅速增长! 如果你不相信我所说的这个列表正在迅速增长,只需看看E2B关于AI代理领域的以下图片。这还不是所有基于代理的工具和框架的完整列表:

LLM

摘要: * 苹果推出M3芯片,使得在MacBook Pro上无缝工作与大型AI变换模型成为可能。 * M3支持高达128GB的内存,革新了AI工作流程。 * 增强的神经引擎加速了机器学习模型,同时优先考虑隐私。 * 开发者可以在14英寸MacBook Pro上运行庞大的开源LLM,几乎不损失质量。 * AMD、英特尔、高通和英伟达等其他参与者也在AI开发上投资。 * 苹果的M3芯片比M1和M2芯片提供了显著的性能改进。 * 重新设计的GPU架构提高了GPU利用率并提升了性能。 * 在不断演变的AI领域,苹果成为AI开发者的首选。 主要AI新闻: 在人工智能(AI)和机器学习(ML)的世界中,苹果最近推出了M3芯片,这是一项改变游戏规则的创新,迅速赢得了AI开发者的青睐。这些先进的M3芯片使开发者能够在他们的MacBook设备上无缝地工作与拥有数十亿参数的大型变换模型。苹果在最近的博客文章中自豪地宣布,M3芯片支持高达惊人的128GB内存,解锁了此前在笔记本电脑上被认为是不可能的工作流程。 目前,M3芯片专为14英寸MacBook Pro提供,提供M3、M

LLM

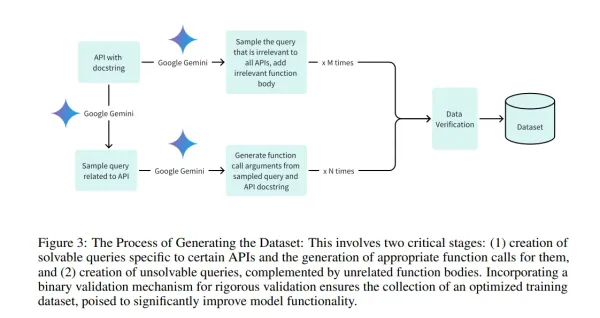

* 斯坦福大学推出章鱼v2,这是一个突破性的设备上语言模型,旨在解决现有模型相关的延迟、准确性和隐私问题。 * 章鱼v2大幅减少了设备上应用的延迟,并提高了准确性,效率和速度超过GPT-4,同时将上下文长度减少了95%。 * 方法论涉及对一个从Gemma 2B衍生的20亿参数模型进行微调,这个模型专注于针对Android API调用的定制数据集,并融入功能性令牌以精确调用函数。 * 章鱼v2在函数调用任务中实现了99.524%的惊人准确率,每次调用的延迟最小化到0.38秒,并且只需要5%的上下文长度进行处理。 主要AI新闻: 在人工智能(AI)领域,特别是在大型语言模型(LLMs)的领域,追求模型效率与现实世界限制(如隐私、成本和设备兼容性)之间平衡的需求一直是一个迫切的问题。尽管基于云的模型拥有卓越的准确性,但它们依赖于持续的互联网连接、潜在的隐私漏洞以及高昂的成本,提出了巨大的挑战。此外,在边缘设备上部署这些模型由于硬件限制而在维持最佳的延迟和准确性上引入了复杂性。 为了提升AI的效率和可访问性,已经进行了许多尝试,例如Gemma-2B、Gemma-7B和Ll