OpenAI

OpenAI GPT 4o Mac版本下载地址

这里是下载链接,但即使你是在美国的PLUS用户,也可能不能使用,只能等 https://persistent.oaistatic.com/sidekick/public/ChatGPT_Desktop_public_latest.dmg

OpenAI

这里是下载链接,但即使你是在美国的PLUS用户,也可能不能使用,只能等 https://persistent.oaistatic.com/sidekick/public/ChatGPT_Desktop_public_latest.dmg

引言 在对计算能力的不懈追求中,发生了一次剧变,将并行计算从一个小众追求推向了现代技术不可或缺的基石。在这场革命的前沿,两个巨头在一场影响深远的战斗中争夺霸权:NVIDIA的专有CUDA(Compute Unified Device Architecture)和开放标准OpenCL(Open Computing Language)。这场冲突,对开发者、研究人员和各个领域的组织产生了深远的影响,这是由于对加速计算能力的不满足需求所驱动的,用于应对从人工智能和科学模拟到多媒体处理等日益复杂的挑战。 随着对计算资源需求的持续激增,利用硬件加速器的大规模并行能力,特别是图形处理单元(GPUs),已成为一项关键任务。CUDA和OpenCL已成为推动这一GPU加速革命的驱动力,每种技术都提供了一种独特的方法来释放这些专用处理器的巨大潜力。 然而,这场战斗远远超出了CUDA和OpenCL的范围。随着网络继续推动可能的边界,一个新的竞争者进入了战场:WebGPU,一个网络标准,承诺将GPU加速带入JavaScript和浏览器的世界。此外,异构计算架构的兴起进一步复杂了局面,这些架构将CPU、GPU

LLM

摘要: * 苹果推出M3芯片,使得在MacBook Pro上无缝工作与大型AI变换模型成为可能。 * M3支持高达128GB的内存,革新了AI工作流程。 * 增强的神经引擎加速了机器学习模型,同时优先考虑隐私。 * 开发者可以在14英寸MacBook Pro上运行庞大的开源LLM,几乎不损失质量。 * AMD、英特尔、高通和英伟达等其他参与者也在AI开发上投资。 * 苹果的M3芯片比M1和M2芯片提供了显著的性能改进。 * 重新设计的GPU架构提高了GPU利用率并提升了性能。 * 在不断演变的AI领域,苹果成为AI开发者的首选。 主要AI新闻: 在人工智能(AI)和机器学习(ML)的世界中,苹果最近推出了M3芯片,这是一项改变游戏规则的创新,迅速赢得了AI开发者的青睐。这些先进的M3芯片使开发者能够在他们的MacBook设备上无缝地工作与拥有数十亿参数的大型变换模型。苹果在最近的博客文章中自豪地宣布,M3芯片支持高达惊人的128GB内存,解锁了此前在笔记本电脑上被认为是不可能的工作流程。 目前,M3芯片专为14英寸MacBook Pro提供,提供M3、M

LLM

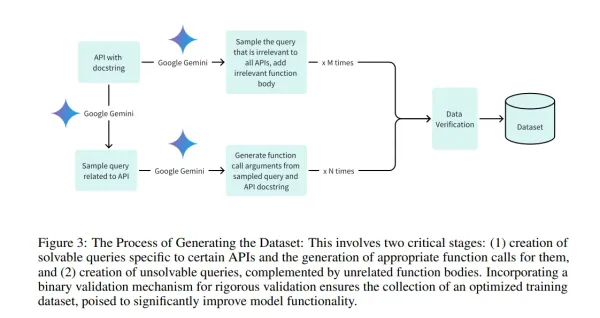

* 斯坦福大学推出章鱼v2,这是一个突破性的设备上语言模型,旨在解决现有模型相关的延迟、准确性和隐私问题。 * 章鱼v2大幅减少了设备上应用的延迟,并提高了准确性,效率和速度超过GPT-4,同时将上下文长度减少了95%。 * 方法论涉及对一个从Gemma 2B衍生的20亿参数模型进行微调,这个模型专注于针对Android API调用的定制数据集,并融入功能性令牌以精确调用函数。 * 章鱼v2在函数调用任务中实现了99.524%的惊人准确率,每次调用的延迟最小化到0.38秒,并且只需要5%的上下文长度进行处理。 主要AI新闻: 在人工智能(AI)领域,特别是在大型语言模型(LLMs)的领域,追求模型效率与现实世界限制(如隐私、成本和设备兼容性)之间平衡的需求一直是一个迫切的问题。尽管基于云的模型拥有卓越的准确性,但它们依赖于持续的互联网连接、潜在的隐私漏洞以及高昂的成本,提出了巨大的挑战。此外,在边缘设备上部署这些模型由于硬件限制而在维持最佳的延迟和准确性上引入了复杂性。 为了提升AI的效率和可访问性,已经进行了许多尝试,例如Gemma-2B、Gemma-7B和Ll

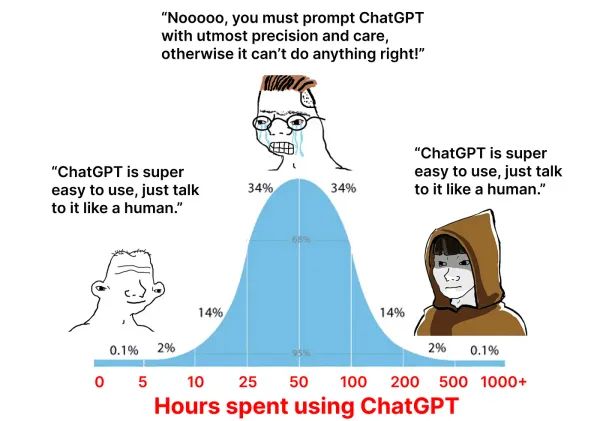

我与ChatGPT的关系很复杂。我几乎尝试了它能做的所有事情,深入分析了它的输出,并使用API创建了许多应用程序和工具。你可以想象,自从它推出的一年半以来,我对它的能力的看法发生了巨大的变化。 我会诚实地说,并不是我对ChatGPT的所有看法都有所提高。事实上,随着时间的推移,对某些用例我实际上变得不那么印象深刻了。有些日子,我坐回来,对它的输出感到惊讶和完全震撼。还有些日子,我因为它的糟糕和不注意而厌恶地退出了我的会话。 然而,我确信,了解它的优点和缺点是成为ChatGPT专家的唯一途径。虽然我仍然不认为自己是一个专家,但我相信我正走在正确的道路上。 这里是我在使用ChatGPT1000多小时中学到的五个最重要的经验。 经验1:信息为王。 ChatGPT依赖于你给它的信息。如果你让它缺乏信息,它每次都会给出不佳的输出。 幸运的是,我很早就发现了这一点。事实上,几个月前,我写了一篇关于这个主题的文章,标题是《最重要的ChatGPT提示》。提示很简单: 在你开始之前,请问我任何你有的澄清问题,这样我可以给你更多信息。请非常全面。 其核心,提示要求ChatGPT通过向你询问关于你想要什么

认为自己家务活干得不错?那么来见见ChatGPT,这个让DIY变得轻而易举的新AI助手。ChatGPT能在几秒钟内完成我们数小时的工作——从基础任务如报时到复杂任务如预测股市。 这个人工智能助手能用自然的人类语言进行交流,并且能比你说出“你是怎么做到的?”更快地完成50多种不同的任务。 从按字母顺序排列购物清单到写出能让华兹华斯流泪的诗,ChatGPT证明了AI已经远远超出了人类的能力范围。 所以,拿起咖啡,舒服地坐下来,一起探索这个全明星AI让艰难任务变得轻而易举的无数方式。未来已经到来,它的名字是ChatGPT! 50个ChatGPT能在几秒内完成的任务,仅需这些简单提示: 1. 显示当前时间 2. 打印给定消息 3. 计算字符串中的字符数 4. 将文本转换为大写/小写 5. 重复一条信息若干次 6. 反转一个字符串 7. 检查一个数字是奇数还是偶数 8. 生成一个随机数 9. 检查一个数字是否为素数 10. 查找两个数字的最大公约数 11. 按升序或降序排序数字列表 12. 计算列表中数字的和 13. 检查字符串是否为回文 14.

1. ChatGPT * 理想用途:最受欢迎的AI聊天机器人 * 优点:界面简洁,频繁更新,功能多样 * 缺点:用户抱怨其性能随时间降低 * 升级选项:ChatGPT Plus提供GPT-4访问权限,月费20美元,包含多种功能。对SEO、编码人员、喜欢调整不同角色的人非常有用。 * 如果你寻求站在技术前沿的AI聊天机器人体验,那么ChatGPT是你的首选。由OpenAI开发,通过2022年11月的广泛预览迅速走红,这款尖端聊天机器人迅速积累了超过1亿的热情用户群,网站每月访问量高达18亿次,证明了其广泛的吸引力和影响力。 * ChatGPT引发了争议,尤其是用户发现其在学术任务和工作替代中的潜在应用。OpenAI民主地开放了ChatGPT的大门,允许用户免费注册后通过GPT-3.5模型利用其能力。对于寻求更高体验的用户,Plus版本提供了访问强大的GPT-4和一系列增强功能,仅需20美元/月。 * GPT-4被誉为所有AI聊天机器人中最广泛的大型语言模型(LLM),以2022年1月的数据训练为领导,并增加了通过Microsoft

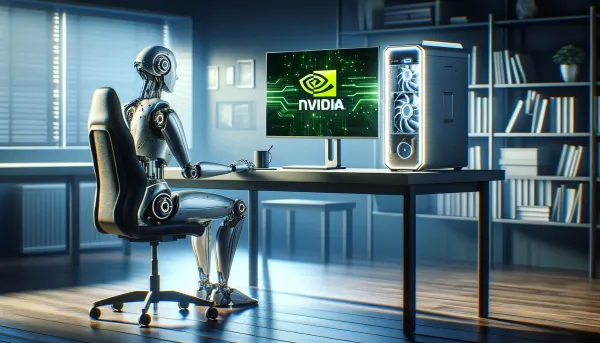

在这个快速指南中,我将向你展示Nvidia的一款全新软件——RTX聊天。你会在下面的描述中找到这个链接。我会向你展示如何安装它,当然,也会告诉你如何使用它。 它到底是什么呢?嗯,你可能之前已经使用过像ChatGPT、Gemini等聊天模型,但这个是运行在你的PC上的。这是Nvidia自己的一个演示,使用当前非常火的模型,给你提供了一个你可以互动的聊天界面。当然,这个东西也可以与你的文档互动,所以你可以对文件夹中的一堆文档提出问题。 GitHub - NVIDIA/trt-llm-rag-windows:一个为在Windows上使用TensorRT-LLM创建检索增强生成(RAG)聊天机器人的开发者参考项目... 安装和开始使用都很简单,但有一些要求。在这个页面上,你可以点击“系统要求”,向下滚动,你会看到你需要: Windows 16GB或更多的RAM Windows 11驱动535或更高版本 一个RTX 30或40系列显卡,或者RTX安培或带至少8GB VRAM的一代显卡 但对于大多数拥有较新显卡进行游戏等活动的人来说,你可能能够满足这个要求。 请记住,如果你想使用一个

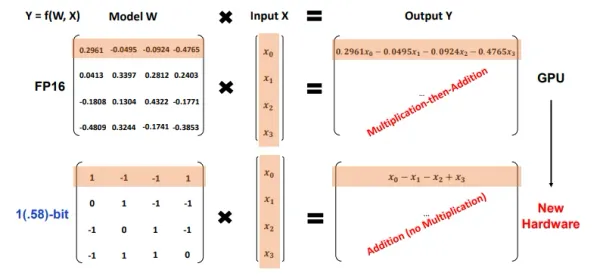

在人工智能界,最新加入的是1位大语言模型(LLMs)。你可能难以置信,但这能改变很多事情,并有望解决LLMs面临的一些主要挑战,特别是它们庞大的体积问题。 通常(不总是),不管是LLMs还是逻辑回归,机器学习模型的权重通常存储为32位或16位浮点数。这就是我们无法在个人电脑和生产环境中使用GPT或其他大型模型的原因,因为这些模型由于高精度权重而体积巨大。比如,假设我们有一个名为“MehulGPT”的LLM,它有70亿参数(类似于Mistral或Llama-7B),使用32位精度(每个4字节)。该模型将占用 总内存 = 单个权重大小 * 权重数 总内存 = 4字节 * 70亿 总内存 = 280亿字节 换算成千兆字节(GB): 总内存 = 280亿字节 / 1024³字节每GB 总内存 ≈ 26.09 GB 这个体积非常大,导致许多设备,包括手机,因为没有足够的存储或处理能力而无法使用它。 那么如何让小型设备和手机也能使用LLMs呢? 1位LLMs 在1位大语言模型中,与传统LLMs的32/16位不同,权重参数只用1位(

lama.cpp允许你在自己的电脑上运行大型语言模型(LLM)。影响性能的关键因素包括CPU、GPU、RAM的大小与速度,以及所用的模型。这里是一个概览,帮助你决定应该选择哪种电脑和量化方式。特别强调这里说的是苹果硅片机Apple Silicon,因为它们支持大容量和高速度的RAM。 Georgi的创新使我们能够通过llama.cpp在本地运行LLM,并且功能不断增加。模型量化也很关键,因为它减小了存储需求。现在,我们可以使用多种技能和量化格式的LLM,例如在huggingface/theBloke上(请注意,要运行llama.cpp需要GGUF模型格式)。Georgi最近还开始了一个仅针对苹果硅片的性能统计比较,提供数据帮助我们在硬件选择和量化效果上做出决策。以下是我的一些主要观点,这些观点通过我的本地实验得到增强。 LLM的“回答”性能(为单个用户生成令牌)主要取决于: a) 可用的RAM需大于模型的内存需求 — 参见huggingface上的模型说明。 在GPU上运行通常比在CPU上快得多,但具体快多少则取决于GPU和CPU的性能。 llama.cpp允许模型在GPU或仅CP